Możliwość maszynowego odczytania dawnych tekstów rękopiśmiennych – polskich, łacińskich, niemieckich, duńskich, francuskich czy arabskich – niemal rewolucyjnie zmienia pracę nad źródłami historycznymi i jest dowodem na skuteczność sztucznej inteligencji w konkretnych, niszowych zadaniach.

Dziś rzadko posługujemy się pismem ręcznym, nawet szybkie notatki robimy w specjalnych aplikacjach. Nie tylko w pracy naukowej, ale na co dzień korzystamy z rozwiązań optycznego rozpoznawania znaków (OCR, ang. optical character recognition), które pozwala wyodrębnić ze skanów i obrazów warstwę tekstu. OCR sprawdza się jednak wyłącznie przy tekstach w określonym standardzie – pisanych na maszynie czy drukowanych, tam, gdzie poszczególne litery mają podobny kształt.

A co z pismem ręcznym? Sztuczna inteligencja dostępna w naszych telefonach daje nam możliwość przepisywania tekstu ze zrobionych przed chwilą zdjęć, nawet jeśli to zdjęcie pisanych na szybko w brulionie notatek. Przetwarzanie obrazu na tekst jest dziś łatwiejsze niż kiedykolwiek. Kiedy jednak pracujemy ze specyficznymi dokumentami z epoki i zależy nam na najwyższej jakości, zwykłe, ogólnodostępne aplikacje nie wystarczają.

Kolekcje jako dane

Biblioteki i archiwa digitalizują i udostępniają miliony dokumentów rękopiśmiennych. To kroniki, listy, pamiętniki, sprawozdania i indeksy, które wykorzystywać można w badaniach historycznych czy językowych. Ich analiza nie musi być łatwa, także ze względu na liczbę dostępnych źródeł i charakter pisma, charakterystyczny dla wybranego autora czy kancelarii.

Dzięki maszynowemu przekształceniu skanów rękopisów na tekst zdatny do odczytu i analizy komputerowej biblioteki i repozytoria udostępniające takie zbiory można już przeszukiwać pełnotekstowo. Co więcej, dostęp do warstwy tekstowej rękopisów pozwolił na zastosowanie metod humanistyki cyfrowej do badania źródeł historycznych. Dawne rękopisy przestają w takiej sytuacji być jedynie wizerunkami dokumentów (skanami) i zostają przekształcone w dane. Biblioteki, archiwa czy instytucje badawcze udostępniają je w stanie gotowym do analizy, wizualizacji i dalszego wykorzystania.

Tysiące rozwiązań dla tysięcy problemów

„Technologia rozpoznawania pisma odręcznego (HTR, ang. handwritten text recognition) to obecnie dojrzałe narzędzie uczenia maszynowego, zdolne do dokładnego przekształcania obrazów historycznych rękopisów w tekst przetwarzalny maszynowo” – czytamy w artykule „Rozpoznanie wykorzystania technologii rozpoznawania pisma odręcznego w kontekście dziedzictwa kulturowego: systematyczny przegląd wykorzystania Transkribusa w publikowanych badaniach” (2022). Transkribus to narzędzie naukowe, które pozwala na odczytywanie pisma ręcznego i trenowanie własnych modeli, dostosowanych do odczytywania wybranych źródeł.

Podobnie jak OCR, HTR wykorzystuje dziś rozwiązania AI. Rozpoznawanie liter i słów nie jest tu prostym porównywaniem tekstu źródłowego ze wzorcem, ale pracą z rozmaitymi modelami, trenowanymi na bardzo konkretnych, specyficznych zbiorach tekstów. Można oczywiście próbować rozpoznawać teksty średniowiecznych kronik czy nowożytnych pamiętników za pomocą ogólnych narzędzi takich jak ChatGPT, ale nie są to rozwiązania sprawdzające się w zastosowaniach naukowych. Potencjał sztucznej inteligencji w badaniach historycznych czy językowych często leży w małych, dostosowanych odpowiednio modelach, czyli specyficznych wzorcach pisma, za pomocą których chce się odczytywać dawne teksty.

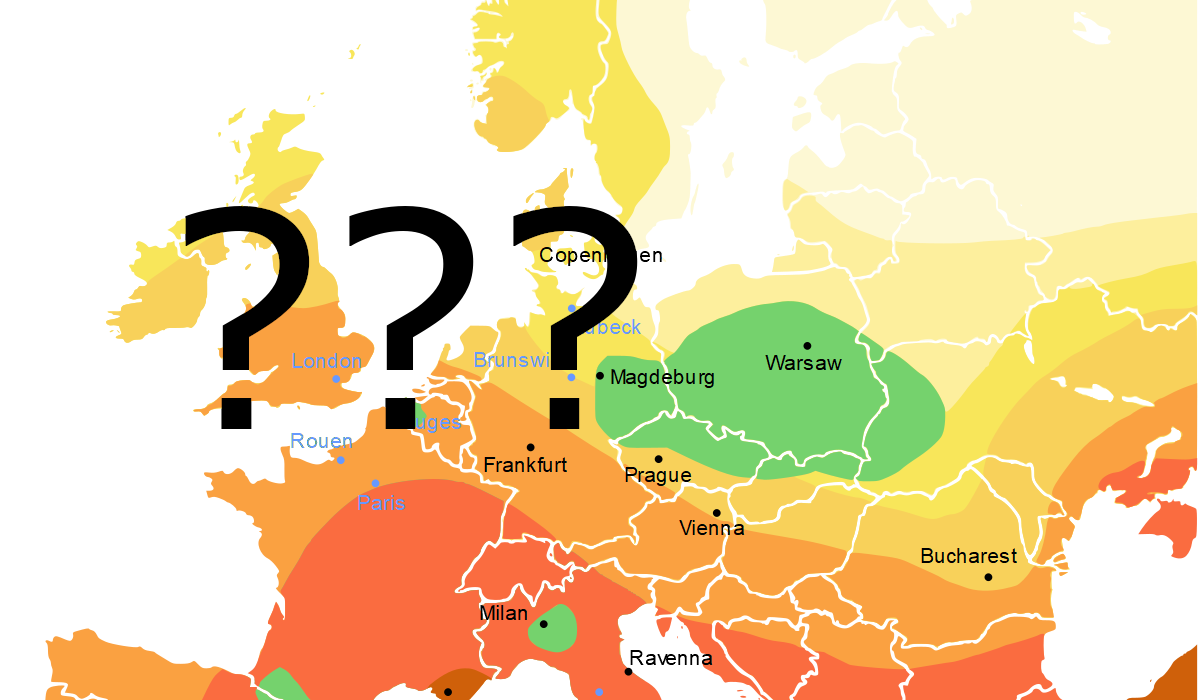

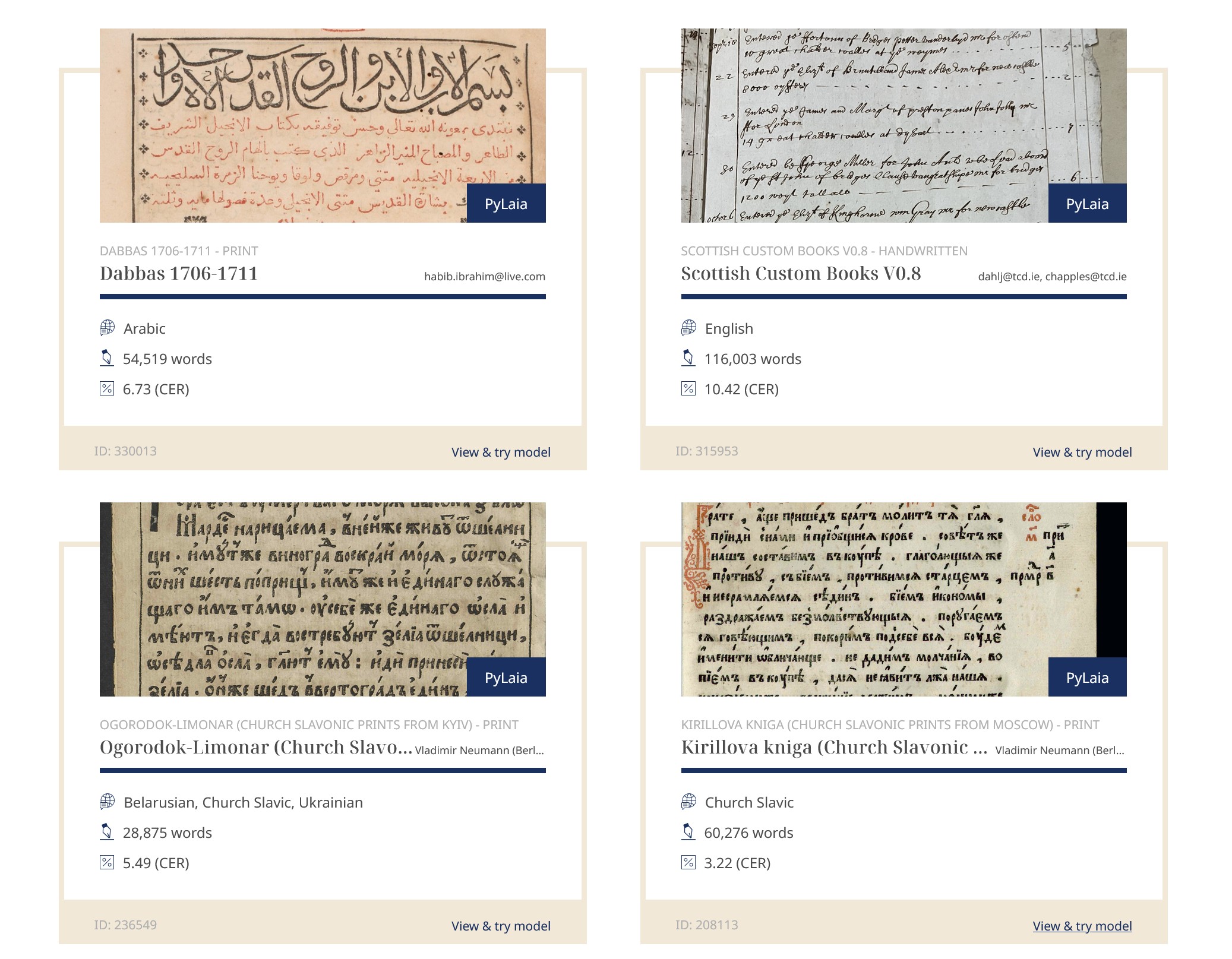

Na platformie Transkribus dostępnych jest publicznie i za darmo ponad 250 z ogólnej puli ponad 20 tys. modeli do odczytywania pisma ręcznego, które wytrenowano do tej pory w ramach poszczególnych projektów. Są wśród nich modele do odczytywania ksiąg liturgicznych i teologicznych drukowanych w Kijowie w XVIII wieku, modele trenowane na tekstach z biskupiego skryptorium z Wormacji z XI wieku czy ułatwiające rozczytanie listów wysyłanych przez żołnierzy z Finlandii z frontów II wojny światowej. W katalogu dostępnych publicznie modeli znajdziemy także taki przeznaczony do języka polskiego oraz modele do rozpoznawania tekstów w jydisz, sanskrycie czy języku łacińsko-jawajskim.

Nie wszystko da się zautomatyzować

Z Transkribusa korzystał też zespół Pracowni Historii Języka Polskiego XVII i XVIII wieku IBL PAN w pracy nad korpusem polskich tekstów z tego okresu. Na początku zdecydowano się na ręczną transkrypcję dokumentów, ponieważ żadne oprogramowanie nie było w stanie skutecznie wyodrębnić tekstów drukowanych różnymi czcionkami czy pisanych różnym charakterem, w których współistnieją ze sobą frazy w języku polskim, łacińskim, niemieckim czy francuskim. Dr Ewa Rodek, członkini zespołu pracującego nad korpusem, zwraca uwagę także na koszty manualnej transkrypcji tekstu pisanego gotykiem. Na bazie platformy Transkribus badacze z IBL PAN opracowali dwa własne modele, jeden do tekstów wydawanych drukiem, drugi do rękopisów. Poziom błędów maszynowego rozpoznawania znaków udało się im utrzymać na poziomie nie większym niż 1,8%.

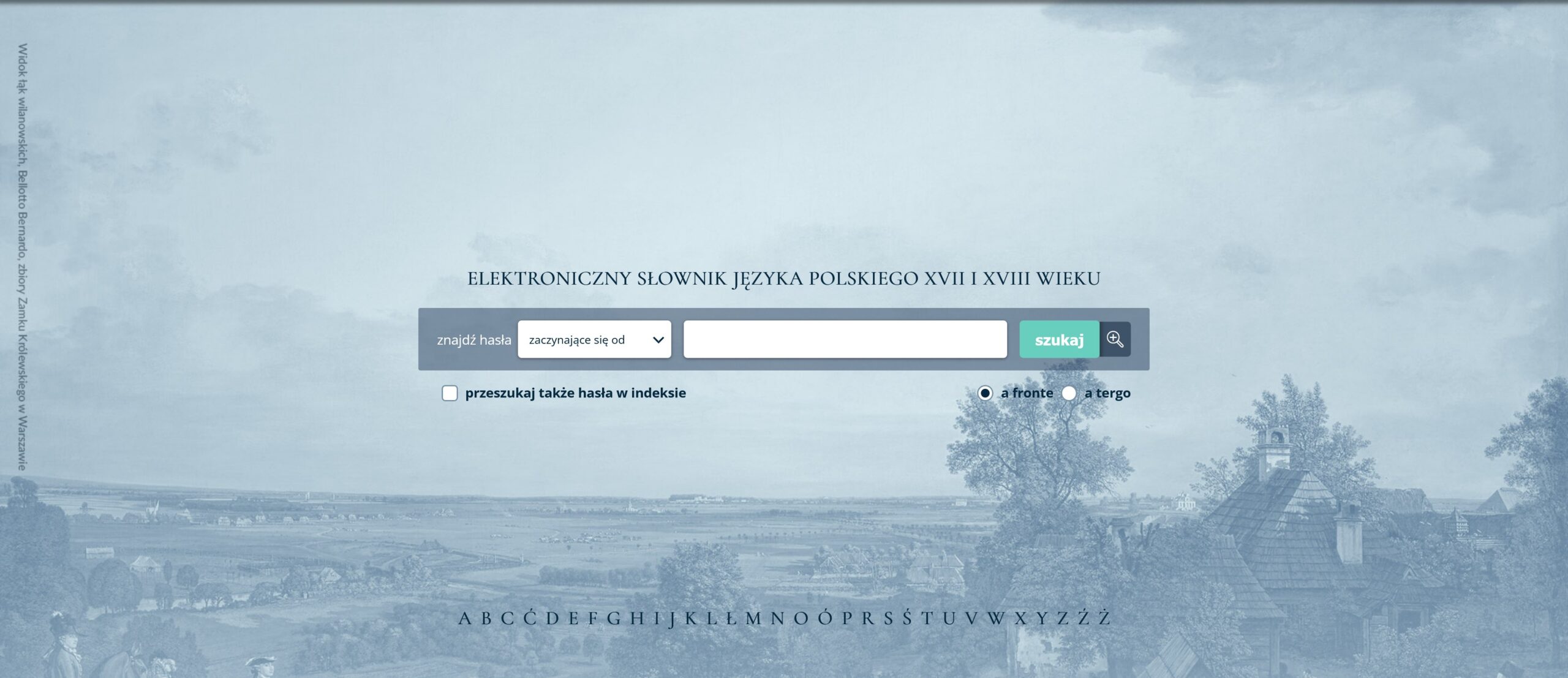

Korpus jest też podstawą pracy nad Elektronicznym słownikiem języka polskiego XVII i XVIII wieku, również opracowywanym w IBL PAN. Został on zainicjowany jeszcze w połowie lat 60., kiedy hasła i opisujące je cytaty przechowywano na 2,8 mln drukowanych fiszek. Z gromadzenia danych w postaci papierowej zrezygnowano dopiero w 2004 roku, a dziś w bazie słownika znajduje się ponad 50 tys. haseł – w tym niestety tylko 1 proc. należy do w pełni opracowanych.

Czy narzędzia sztucznej inteligencji mogłyby pomóc w redakcji haseł i przyspieszyć uzupełnianie bazy? W artykule podsumowującym jego historię możemy przeczytać, jak wielką jakościową zmianą było przejście z kartoteki papierowej na bazę danych. Dzięki temu struktura słownika może być nieustannie poprawiana, a hasła edytowane i automatycznie ze sobą wiązane. Cyfrowa postać haseł na pewno pozwala na zastosowanie narzędzi sztucznej inteligencji, pozwalających np. na automatyczne wyodrębnianie znaczeń z tekstów źródłowych (NER), jednak na pewno nie zastąpi krytycznej i żmudnej pracy badaczy i badaczek nad ich opracowaniem.